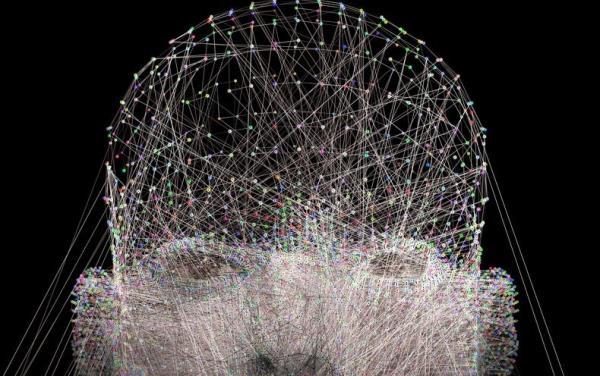

人工智能(AI)正处于医疗保健领域的拐点。50年的算法和软件开发已经产生了一些从大数据中提取模式的强大方法。例如,深度学习神经网络已被证明在图像分析方面是有效的,这导致了fda批准的第一个人工智能辅助诊断一种名为糖尿病视网膜病变的眼病,仅使用患者眼睛的照片。

然而,世界卫生组织(世卫组织)最近的一份指导文件概述了人工智能在医疗保健领域的应用,也揭示了它的许多弱点。该文件涵盖了一长列主题,每个主题都同样重要:负责任、可问责、包容、公平、道德、公正、响应性、可持续、透明、值得信赖和可解释的人工智能。这些都是提供卫生保健至关重要的,并与我们在患者的最大利益是最重要的情况下处理医学的方式一致。

不难理解一个算法可能是有偏见的、排他性的、不公平的或不道德的。这可以解释为,它的开发人员可能没有赋予它分辨好数据和坏数据的能力,或者他们没有意识到数据问题,因为这些问题通常是由人类的歧视性行为引起的。一个例子是无意识地根据皮肤颜色对急诊室的病人进行不同的分类。算法擅长利用这些类型的偏见,并且让它们意识到这些偏见可能具有挑战性。正如世卫组织指导文件所建议的那样,我们必须仔细权衡人工智能的风险和潜在收益。

但更难以理解的是,为什么AI算法可能不透明、不可信、也无法解释。透明意味着很容易理解人工智能算法、它是如何工作的以及在幕后工作的计算机代码。这种透明度,加上严格的验证,建立了对软件的信任,这对病人的护理至关重要。不幸的是,医疗保健行业中使用的大多数人工智能软件都来自需要保护知识产权的商业实体,因此不愿意泄露他们的算法和代码。这可能会导致人们对人工智能及其工作缺乏信任。

当然,信任和透明是值得追求的目标。但是解释呢?理解AI或AI渴望成为什么,最好的方法之一是思考人类如何解决医疗保健挑战并做出决策。当面对具有挑战性的病人时,向其他临床医生咨询是很常见的。这可以利用他们的知识和经验基础。咨询人类的好处之一是,我们可以在回答后继续问为什么。

“为什么你认为这种治疗方法是最好的?”

“你为什么推荐这个手术?”

一个好的临床医师顾问应该能够解释为什么他们得到了一个特定的建议。不幸的是,现代人工智能算法很少能够为为什么它们认为一个答案是好的这个问题提供答案。这是信任的另一个维度,可以帮助解决偏见和道德问题,也可以帮助临床医生从人工智能中学习,就像他们学习人类咨询师一样。

我们如何解释人工智能?有趣的是,医疗保健领域最早成功的人工智能算法之一是20世纪70年代初由医生兼计算机科学家爱德华·肖特利夫(Edward Shortliffe)开发的MYCIN程序,用于给重症监护病房的患者开抗生素处方。MYCIN是一种被称为专家系统的人工智能,它可以通过回溯概率计算来回答“为什么?”的问题,告诉用户它是如何得到答案的。

这是人工智能的一个重要进步,我们在寻找性能更好的算法时似乎失去了这一点。如果算法的开发者真正理解它是如何工作的,那么可解释的AI应该是可能的。这只是一个简单的问题,即在算法迭代时投入时间和精力跟踪算法,并以人类可以理解的形式为用户呈现它所经过的路径。

换句话说,这应该只是开发人员的优先级问题。任何复杂到开发人员无法理解其工作原理的人工智能算法都可能不适合用于医疗保健。

我们在人工智能领域取得了巨大的进步。我们都对人工智能如何帮助患者感到兴奋。我们也对人工智能的失败感到谦卑,例如最近的研究表明,由于数据存在偏差,用于诊断COVID-19的人工智能结果不可靠。在开发和评估用于临床的人工智能算法时,我们必须牢记临床医生。我们必须不断思考什么对病人有益,以及如何通过使用软件获得临床医生的信任。人工智能的自我解释能力将是关键。

这是一篇观点分析文章;作者或作者所表达的观点不一定是《科学美国人》的观点。